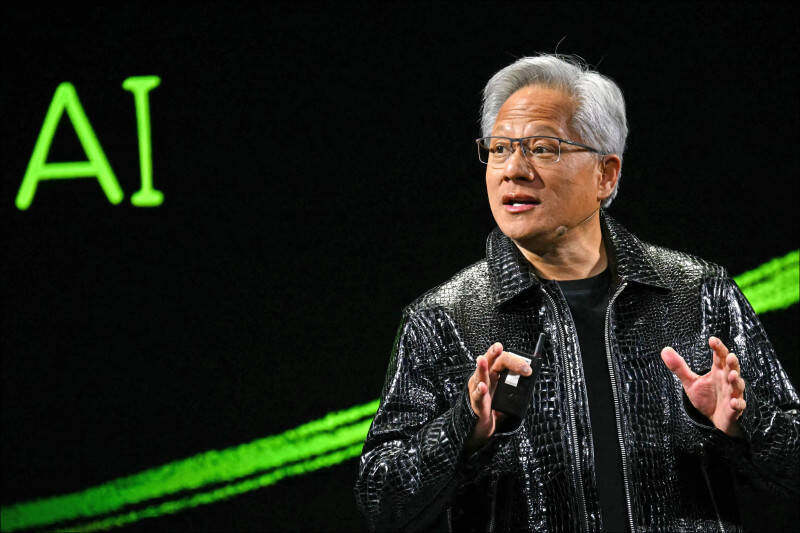

AI推理運算需求爆棚!黃仁勳強調,比LLM多數百萬倍(法新社)

AI推理運算需求爆棚!黃仁勳強調,比LLM多數百萬倍(法新社)

高佳菁/核稿編輯

〔財經頻道/綜合報導〕AI浪潮即將再次引爆,輝達(NVIDIA)執行長黃仁勳表示,公司對AI推理帶來的潛在需求感到興奮,這類運算需求預計將遠超目前大語言模型(LLM),可能需要比現有運算能力高出數百萬倍。

外媒報導,黃仁勳在2025財年第4季財報電話會議上指出,我們所做的事情並不容易,但輝達在提升供應能力方面表現良好,AI軟體將是一切資料中心的一部分,無論是短期、中期或長期跡象都持續向好。

黃仁勳進一步說明,現在有多種運算擴展規律,第1種是預訓練擴展規律,這個趨勢仍會持續成長,因為我們正在進入多模態時代,現在的推理產生資料也可以用於預訓練。

第2種是後訓練擴展規律,它涉及強化學習,包括人類回饋強化學習、AI回饋強化學習,以及可驗證獎勵強化學習。在後訓練階段,所需的計算量實際上比預訓練更大。這也合乎邏輯,因為在使用強化學習時,AI可以產生大量合成資料或合成Token,並利用這些資料進一步訓練AI模型,這就是後訓練。

第3種,測驗時計算或推理、長思考推理擴展,它們本質上都是相同的概念。在推理過程中,我們有練式思維和搜索,所產生的Token量以及所需的推理計算量已經比最初的大語言模型(LLM)中的單步推理高出100倍,而這僅僅是個開始。

未來,我們可能會看到運算需求成長至當前的數千倍甚至數百萬倍,AI模型將變得更加智慧,具備更強的思考能力,並依賴更複雜的模擬和搜尋推理。因此,關鍵問題是如何設計適應這種演進的運算架構?

目前,不同AI模型有不同的架構需求,有些是自迴歸模型,有些是基於擴散的模型。有時,資料中心需要採用分散式推理,有時則需要緊湊式架構。因此,很難確定最優的資料中心架構。

這正是輝達架構如此受歡迎的原因,我們的平台能夠支援所有類型的AI模型,我們不僅擅長訓練,事實上,目前大部分運算資源都用於推理,而Blackwell進一步提升了推理能力。我們在設計Blackwell時,就考慮到了面向推理的需求,讓AI能夠處理更複雜的任務。

在訓練方面,Blackwell的表現已經提升了數倍,但真正令人驚嘆的是,在長思維推理、測驗時擴展、推理AI方面,效能提升更為顯著,推理吞吐量提高了25倍,運算速度提升數十倍,因此,Blackwell在各方面都將帶來卓越表現。

當企業在建立資料中心時,他們需要根據不同階段的需求進行調整,例如目前是否專注於預訓練,是否專注於後訓練,或是否需要大規模擴展推理計算。輝達的架構具有高度靈活性,可以輕鬆適應這些不同的運算模式。

因此,我們觀察到,越來越多的企業正在集中採用統一架構,比以往任何時候都更加明顯,這證明了輝達的架構在各個AI運算環節都具備極高的適用性和領先優勢。

一手掌握經濟脈動 點我訂閱自由財經Youtube頻道

免費訂閱《自由體育》電子報熱門賽事、球星動態不漏接

不用抽 不用搶 現在用APP看新聞 保證天天中獎 點我下載APP 按我看活動辦法